Oubliez le Cloud, la révolution est peut-être déjà sur votre bureau

Cela fait plus de 20 ans que la tech, d'ordinaire très prompte à évoluer et à remettre en question certains dogmes, ne remet pas en cause un élément pourtant central de nos vies numériques. Un élément à la fois omniprésent et invisible, utilisé tous les jours par des millions de personnes à travers le monde sans qu’elles en aient forcément conscience. Cet élément, c’est le jeu d’instructions des microprocesseurs. [MUSIQUE ANGOISSANTE]

UN PEU DE CONTEXTE

Pour résumer très sommairement nous dirons qu’une architecture, ou jeu d’instructions, est l’élément qui permet au microprocesseur (CPU) de faire son travail. (C’est sommaire hein ? J'avais prévenu.)

OK, VRAIMENT, UN PEU DE CONTEXTE

Un jeu d’instructions, c’est un ensemble d’instructions qui permettent au CPU de savoir comment faire son travail de CPU, à savoir, calculer, stocker et gérer ses différents registres. Sans jeu d’instructions, un CPU n’est qu’un amas de transistors inertes. Un amas de haute précision, certes, mais un amas quand même. Le jeu d’instructions le plus connu de nos jours est le x86.

Sans remonter à la préhistoire de l’informatique, précisons qu’à l’origine s’ébattaient dans la nature moult jeux d’instructions, liés aux différents processeurs disponibles sur le marché. On citera par exemple le Zilog Z80 utilisé dans les ordinateurs ZX Spectrum, les MSX, les Amstrad CPC.

On peut également citer le célèbre 68 000 alias "68 k" de Motorola qui a fait les belles heures des premiers Macintosh, de tous les Amiga, de l’Atari ST, des PDA Palm et, côté jeu vidéo, de la Megadrive de SEGA et de la Neo-Geo de SNK.

Le x86 date de cette époque. Jeu d’instruction originellement 16-bit, il est présent depuis l’Intel 8086 et a suivi en s’adaptant chaque génération de CPU de la marque (Intel 80386, 80 486, etc., d’où le sobriquet “x86”).

Le x86 a évolué, est passé en 32 puis 64 bits (déclinaison x64), mais est resté fondamentalement similaire : une architecture au jeu d’instructions complexe (dite “CISC” pour "Complex Instructions Set Computer") quand peu après apparaissaient des architectures au jeu d’instructions réduit (“RISC” ou "Reduced Instruction Set Computer").

Cette opposition CISC contre RISC a, au même titre que les oppositions légendaires Betamax contre VHS ou HD-DVD contre Blu-ray, façonné nos usages et l’informatique telle que nous la pratiquons aujourd’hui.

L’AMOUR DU RISC

Dans les années 80, donc, le RISC a fait son apparition. La simplification du jeu d’instructions étant l’objectif, par définition, tout ce qui existait avant est devenu “complexe” (CISC). Deux types d'architecture de processeur, deux philosophies de design qu’on ne va pas détailler ici, mais tout juste préciserons-nous que là où les CPU CISC se sont mis à stocker du microcode dans la ROM du CPU, le RISC misait tout sur la simplicité des instructions, leur exécution et l’utilisation de la RAM pour stocker les résultats intermédiaires. À une époque où la ROM ne coûtait rien et la RAM coûtait un rein et avec des volumes de production inférieurs, il est simple de deviner quelle architecture le marché a préféré retenir.

D’autant que quand le marketing s’en est mêlé, les pistes ont encore plus été brouillées, notamment avec l’idée, lors de la présentation du 386 d’Intel, que le CPU embarquait en fait du RISC tout en gardant la compatibilité avec x86 pour avoir le meilleur des deux mondes. C’était faux, mais c’était pas grave, dans la tech, le marketing est souvent bien plus mis en avant que la rigueur. Au final, le RISC dans des machines de bureau n'a été adopté que par Apple sous la forme des puces PowerPC mises au point par IBM et Motorola entre 1994 et 2006.

Avance rapide en 2020, le CISC règne donc en maître sur les ordinateurs personnels depuis l’abandon du PowerPC par Apple en 2006, mais tout n’est pas rose pour Intel : le fondeur de Santa Clara est resté bloqué sur des CPU gravés en 14 nm pendant de longues années, AMD revient se positionner en concurrent sérieux avec son architecture Zen et Apple se lance dans le bain en décidant de produire ses propres puces.

MAIS ALORS...

C’EST UNE REVOLUTION ?

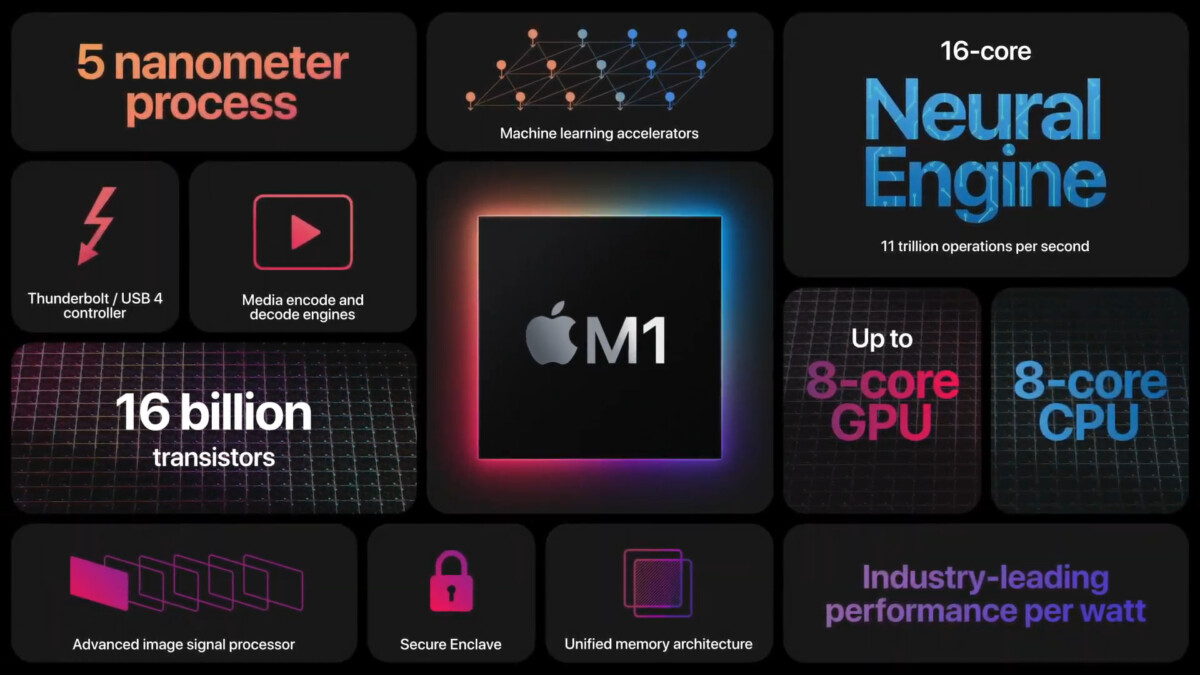

Apple revient donc vers une architecture type RISC en adoptant le M1, un SoC ARM (“Advanced RISC Machines”) de sa conception. Contrairement à Intel, ARM ne fabrique aucun produit. La société conçoit les architectures et laisse à d'autres le soin de fabriquer leurs propres puces. Dans le cas du M1, c'est donc un design d'Apple basé sur le design ARMv8-A, fabriqué par le fondeur TSMC et gravé en 5 nm.

Les machines utilisant cette puce seront d'ailleurs les premiers au monde à utiliser cette finesse de gravure (les Ryzen 5000 d'AMD sont gravés en, 7 nm, la 10e génération de CPU Intel Core est en 10 nm).

Avec le M1, le milieu attendait des transistors de transition, mais, comme l’évoque Julien Cadot chez Numerama :

Nos attentes étaient basses et Apple les a explosées.

Tout simplement. Ne nous perdons pas en benchmarks et tableaux comparatifs, le M1 déglingue le meilleur Core i9 sur la même machine (MacBook Pro) et ne se fait dépasser en multicœurs que par un Mac Pro vendu au minimum 3 fois plus cher. Non, plutôt que la technique, intéressons-nous plutôt à ce que cela sous-entend en termes d’usages. Le M1 permet d’envisager une nouvelle ère de l’informatique mobile avec des machines certes puissantes, mais aussi et surtout une autonomie et un silence en fonctionnement similaires à ce à quoi nous sommes habitués à croiser sur nos tablettes et smartphones.

17 heures d’autonomie en utilisation mixte dans un silence de cathédrale, et si c’était ça le futur ?

UN PIED DANS LA PORTE ?

Car maintenant qu’Apple a montré ce qu’il était possible de faire en repartant sur du RISC, il y a fort à parier que cela donne des idées à d’autres acteurs présents sur le marché de notre bon vieux PC sous Windows, habitué à ne voir que du x86 depuis toujours. Il existe bien d'autres OS compatibles ARM, que l’on parle de Linux ou ses dérivés (sur Odroid, Arduino ou Raspberry Pi), mais dans la majorité des cas, ces OS tournent sur des machines qui adressent des besoins bien particuliers et ne font que rarement jeu égal avec une machine de bureau plus polyvalente.

Microsoft tourne autour du sujet depuis quelques années avec Windows RT devenu Windows 10 on ARM, mais n’avait jamais poussé l’expérimentation plus avant. Cela change depuis quelques mois entre l’annonce assez récente d’une émulation possible des applications x64 (Windows 10 on ARM était jusqu’ici limité aux seules applications 32 bits) et l’annonce totalement récente de Microsoft de vouloir produire ses propres puces ARM pour ses serveurs Azure et ses Surface : tout semble s’aligner pour que 2021 soit une année importante pour l'architecture RISC.

En outre, on parle de plus en plus de l'architecture RISC-V (à prononcer "RISC Five") qui, pour résumer à nouveau, met l'accent sur une simplification du processeur central au profit de l'utilisation de co-processeurs dédiés.

Et, finalement, plus que l'opposition millénaire RISC vs CISC, c'est surtout à un revirement de la réponse à apporter pour contrecarrer le ralentissement de la loi de Moore auquel nous assistons. La loi de Moore originale stipule que la puissance de calcul double tous les ans. Elle a été remixée au fil du temps et désormais on parle d'un doublement des performances tous les 18 mois. Ce qui est remis en question désormais est moins cette injonction que la façon d'y arriver.

Puisqu'on a du mal à aller plus vite, autant tout faire en parallèle ¯\_(ツ)_/¯

Questionner le CPU tout-puissant et ses multiples cœurs au profit d'une simplification du processeur central et de l'adjonction de co-processeurs dédiés, c'est remplacer la puissance par la vitesse dans un domaine où on nous a toujours expliqué que la puissance C'EST la vitesse. Et pour celles et ceux qui se rappellent (ou qui étaient nés), ça ressemble bigrement à ce que Nintendo avait décidé de faire avec sa Super Nintendo, qui adjoignait au brave Ricoh 5A22 des coprocesseurs dédiés pour le son et la vidéo (Ah ! Le fameux mode 7 !).

LE DERNIER CLOUD DANS LE CERCUEIL

Et ces mouvements ont pris le milieu de la tech par surprise, lui qui dernièrement ne jure que par le cloud gaming et le cloud computing comme seuls vecteurs d’innovations valables. On parle ubérisation de nos machines et netflixation (oui, ça se dit) du contenu dans une perpétuelle fuite en avant alors même que le potentiel de nos machines est à peine exploité. Shadow n’est que l’ombre (vous l’avez ?) de ce que le service aurait dû être et côté cloud gaming, on est en passe de compter bientôt plus d’offres que d’utilisateurs.

Et je n'aborde pas la partie infra côté clients avec un déploiement du très haut débit qui semble prendre son temps, mais un éternel optimiste comme Manu vous dira :

Dans 6 mois tout le monde jouera sur Amazon Luna depuis sa connexion 5G !

MARQUE MES MOTS !

Un bon point tout de même pour Stadia et GeForce Now qui, tels des vautours, ont pu profiter de l’accident industriel Cyberpunk 2077 pour pousser leurs offres respectives auprès des gamers déçus.

Bref, oubliez le nuage mes bon(ne)s ami(e)s, le futur se joue en ce moment, sur le sol. Car comme le chante merveilleusement Creative Source :

Tu n'as pas à lever les yeux, parfois les arcs-en-ciel se trouvent sur le sol.