Soli : pour Google, le Pixel 4 n'est que le premier pas vers le contrôle gestuel

Le Google Pixel 4 a été lancé en octobre dernier et il est le premier smartphone à embarquer un capteur radar connu sous le nom de Soli. En théorie, celui-ci permet de reconnaître des mouvements très fins et de les positionner parfaitement dans l'espace afin de créer de nouvelles interactions. En pratique, il permet de changer de chanson en passant sa main devant l'écran et à dire bonjour au Pokémon qui se trouve sur le fond d'écran.

Google a organisé à Paris une table ronde avec Brandon Barbello, chef produit de Soli, afin de nous en dire plus sur ce projet incubé depuis de nombreuses années à Mountain View.

Les origines

Soli est né non pas chez Google à proprement parler, mais chez Motorola en 2014, à l'époque où une bonne part des recherches étaient intégrées à ATAP, l'incubateur de Google (juste avant le rachat de Motorola par Lenovo). Depuis, le projet a été intégré au département R&D de Google et a eu le temps de mûrir pendant plusieurs années pour arriver un jour « sur les Pixel, les appareils de domotique, etc. ». Un premier indice concernant les ambitions de Google à propos du futur de Soli.

Présenté au grand public en 2015, Soli a finalement été miniaturisé afin de tenir dans un smartphone, et le premier à en profiter est le Pixel 4. Mais ce n'est là qu'une première étape, et Brandon Barbello nous a confié avoir de grandes ambitions pour Soli. Le but à terme est de rendre nos interactions avec la technologie, « plus humaines », bien loin des lignes de code qu'il était obligatoire de taper il y a encore de cela quelques dizaines d'années seulement. Aujourd'hui, nous communiquons avec nos smartphones, nos enceintes connectées ou nos montres connectées par le biais d'une interface tactile, de la voix... et des gestes.

Une infinité de possibilités

La déception qui entoure le lancement de Soli sur les Pixel 4 est en grande partie liée aux présentations passées. Si les interactions avec le dernier smartphone de Google sont assez limitées, les premiers cas d'usages annoncés par Google montraient une finesse d'utilisation millimétrique. Il est triste de voir que la première application concrète est un changement de chanson déjà possible depuis des années avec le simple capteur photo frontal de n'importe quel smartphone.

Néanmoins, le capteur radar embarqué dans le Pixel 4 est tout à fait capable, dans l'absolu, des mêmes prouesses techniques et il suffirait d'une simple mise à jour logicielle pour faire évoluer les capacités du smartphone. Il ne sera donc pas nécessaire d'attendre un Pixel 5 pour voir apparaître de nouvelles fonctionnalités liées à Soli.

Si Brandon Barbello n'a pas souhaité nous révéler les prochains projets de Google (logique), il n'a pas hésité à nous expliquer que Soli pourrait être d'une grande aide sur des appareils munis d'un petit écran comme une smartwatch (pratique avec le rachat de Fitbit), ou pour reconnaître différents mouvements tout autour d'une enceinte connectée (pour les nouveaux produits Nest). Des recherches ont même été réalisées du côté du jeu vidéo pour remplacer nos habituelles manettes (un ajout futur pour Stadia ?).

Pour revenir aux smartphones, Brandon Barbello nous explique aussi que les ondes radar traversent la matière et qu'il serait donc facile de créer des boutons virtuels sur la coque du téléphone avec cette technologie.

Un premier pas hésitant

Malgré toutes ces possibilités, pourquoi donc avoir lancé une technologie qui semble finalement si peu aboutie sur le Pixel 4 ? À cela, Brandon Barbello nous explique que l'intégration à un smartphone était l'étape la plus évidente pour permettre à n'importe qui d'appréhender cette nouvelle technologie, puisqu'il s'agit là de l'appareil à la fois le plus répandu et surtout celui que l'on ne quitte jamais ou presque. Commencer à découvrir les gestes de Soli chaque jour sur son smartphone devrait rendre plus naturelle la navigation par gestes, et sur tous les autres appareils de notre quotidien, comme nos ordinateurs, nos TV, etc.

Malheureusement, un smartphone possède déjà un écran tactile avec lequel nous interagissons, mais aussi des boutons. Google ne voulait pas seulement dupliquer les fonctionnalités avec Soli (amusant quand on sait qu'il y a au moins 4 façons différentes et bientôt 5 de réveiller Google Assistant depuis l'écran d'accueil du Pixel 4).

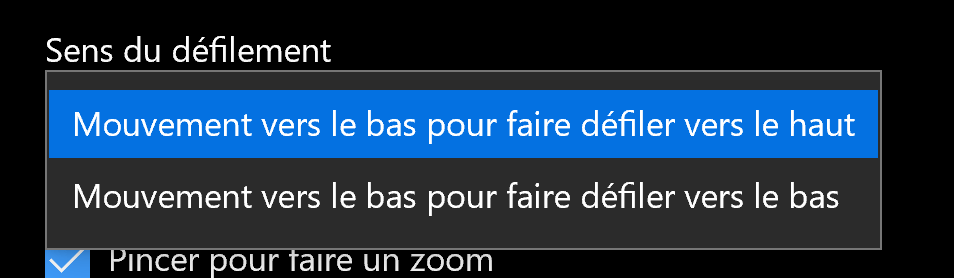

En dehors de ce problème, il fallait étudier le geste qui serait le plus intuitif pour les utilisateurs. « Nous avons recueilli des millions de gestes de la part de dizaines de milliers de personnes », nous précise Brandon Barbello, « vous leur dites de "swiper" et toutes sortes de choses différentes se produisent ». Ce problème, nous l'avons rencontré par exemple à la rédaction de FrAndroid où certains d'entre nous trouvent contre-intuitif de passer une musique en glissant la main de droite à gauche (comme pour tourner la page d'un livre) alors que le sens de lecture naturel est de gauche à droite. Ce dilemme se retrouve également sur les pavés tactiles des ordinateurs portables qui proposent de choisir le sens de défilement.

Finalement, « il était très important de faire progresser la technologie de cette manière pour avoir un produit à échelle commerciale qui peut maintenant être une plateforme pour développer ce qui va suivre de manière bien plus fiable et stable que les plates-formes internes que [Google] avait avant ». De la sorte, il peut être envisagé par Google d'obtenir de l'aide et des informations à plus grande échelle.

Une ouverture à venir

Une fois cette technologie mieux domptée par Google, la firme de Mountain View devrait permettre à d'autres de l'utiliser afin de développer encore plus de cas d'usages encore. Après tout, c'est comme ça que fonctionne Android et certaines des meilleures fonctionnalités du système ont été imaginées à la base par des constructeurs tiers ou des développeurs indépendants.

La question reste de savoir à quel endroit du pipeline il faut ouvrir l'accès aux développeurs. Pourront-ils travailler à partir des gestes des utilisateurs interprétés par Soli ? Des données brutes captées par le radar ? La question reste encore en suspens pour le moment afin de donner assez de liberté créative aux développeurs tout en laissant le développement simple et non intrusif.

Alors oui, Soli ne fait peut-être pas vraiment rêver aujourd'hui, mais le Pixel 4 n'a fait pour le moment qu'effleurer ses possibilités. Espérons que Google ira au fond des choses et n'abandonnera pas sa technologie comme il a pu le faire avec Daydream par exemple.