Nvidia Hopper H100 donne le tournis : le plus gros GPU au monde, 3x la puissance d'Ampere

Deux ans après la présentation de l’architecture Ampere qui a brillamment animé les GeForce RTX 3000, les puces série A pour les Data Center et les puces RTX série A pour les PC professionnels, Nvidia dévoile une nouvelle architecture : Hopper.

Une architecture pour les pro

Il faut tout d’abord faire un point d’explication important. Là où Ampere était une architecture pensée à la fois pour le marché du gaming et celui des professionnels, Nvidia a fait le choix de travailler sur deux architectures pour sa nouvelle génération de produits. Lors de la GTC mardi, sa conférence destinée aux développeurs, Nvidia a dévoilé Hopper pour les professionnels, et on attend pour la rentrée l’architecture Ada Lovelace pour les GeForce RTX 4000.

Toutefois, il reste très intéressant de découvrir les nouveautés proposées par Hopper pour y discerner ce que Nvidia pourrait apporter au grand public dans les années à venir.

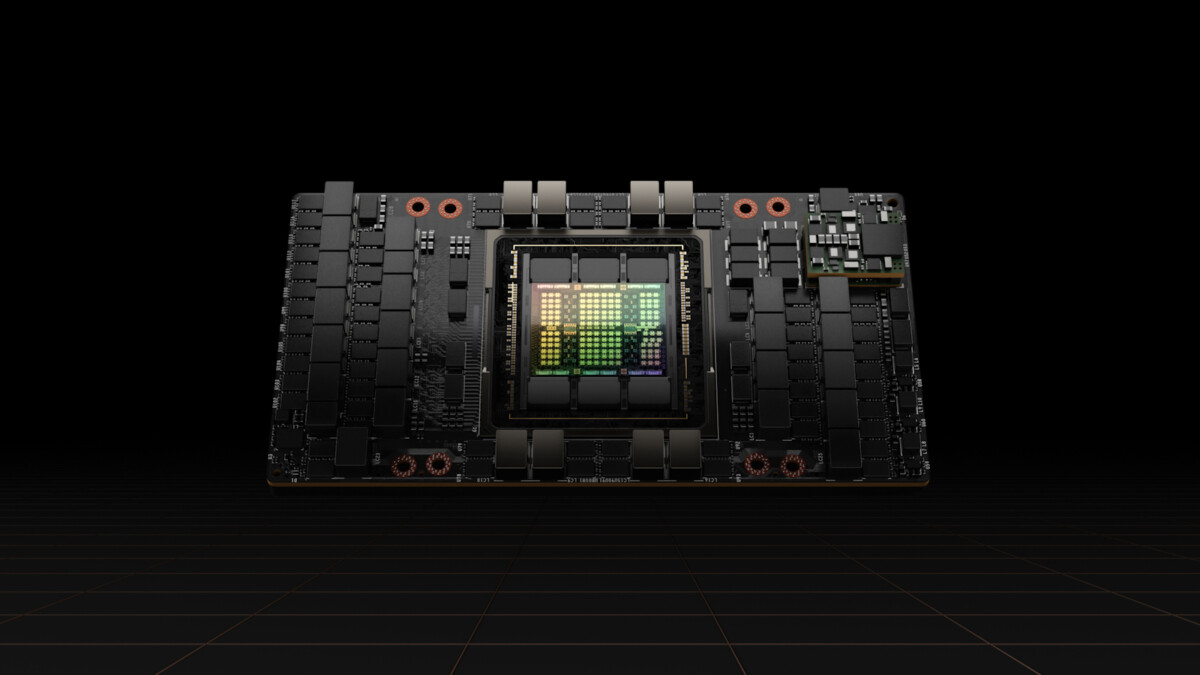

80 milliards de transistors, fabrication en 4 nm

C’est l’annonce de tous les superlatifs pour Nvidia. La firme a présenté à la fois l’architecture Hopper et la puce H100, la première à utiliser cette architecture. Une puce qui va tout de même réunir 80 milliards de transistors, en faisant le plus gros et le plus puissant des accélérateurs au monde, d’après Nvidia. On est sous les 114 milliards de transistors de la puce Apple M1 Ultra, mais cette dernière est un SoC intégrant de nombreux composants.

Pour réaliser cette puce, Nvidia fait appel à TSMC et son nouveau process de fabrication en 4 nm. Rappelons que Nvidia avait choisi Samsung comme partenaire de fabrication des puces Ampere en 8 nm. Cette puce pourra être associée avec de la mémoire HBM3 de dernière génération, permettant une bande passante de 3 To/s. Avec une telle bande passante, Nvidia annonce qu’il suffit de 20 puces Hopper H100 pour supporter le trafic mondial sur internet. De quoi imaginer des applications dans le domaine de l’IA à échelle mondiale et en temps réel.

Autre élément caractéristique de Hopper : le passage à la 4e génération de Nvidia NVLink, qui permet de monter en échelle jusqu’à 256 puces H100 dans un datacenter, en améliorant jusqu’à 9x la bande passant en comparaison de la génération précédente. La puce H100 est la première à gérer nativement le PCI Express 5.0 pour maximiser la bande passante sur les serveurs utilisant ce protocole.

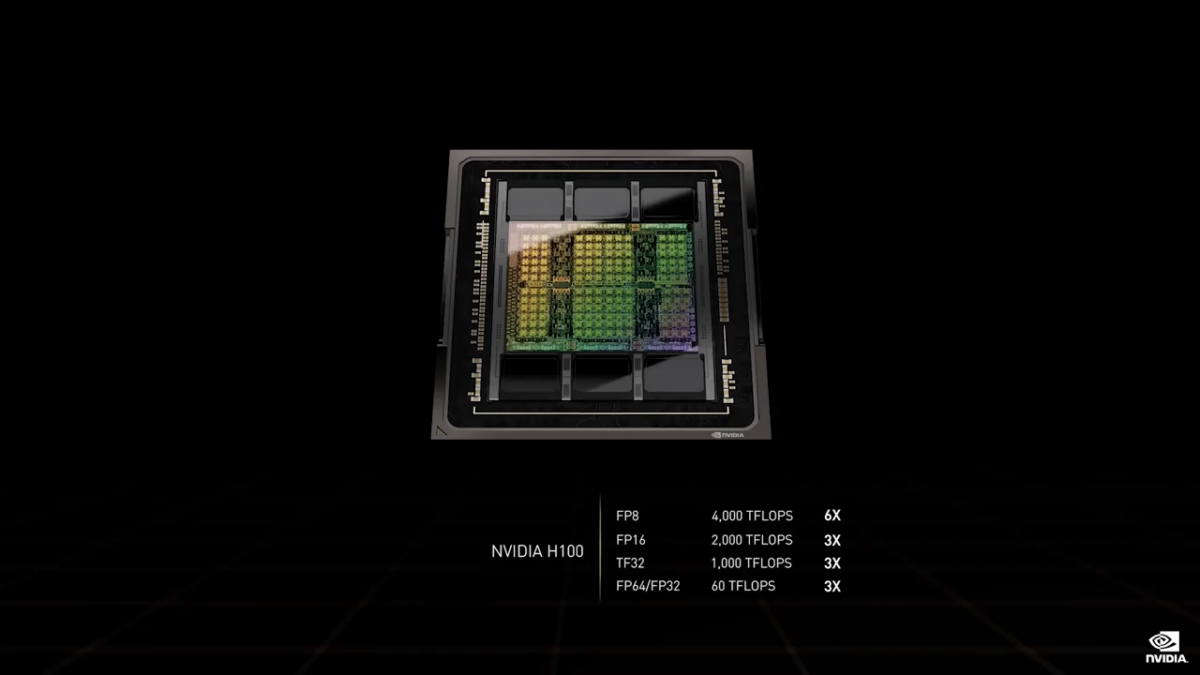

Face à Ampere, Nvidia n'hésite pas à annoncer une amélioration de la puissance de calcul de 3 à 4x pour atteindre des niveaux qui donnent le vertige : 4000 TFlops en FP8, 2000 TFLOPS en FP16 et 60 TFLOPS en FP32/FP64.

Le moteur Nvidia Transformer Engine

Au centre de l’architecture Nvidia Hopper, on trouve le Transformer Engine qui doit augmenter sensiblement les capacités et performances en IA de la puce. Le nom fait une directe référence au transformeur, une technologie de plus en plus populaire et prometteuse dans le domaine de l’intelligence artificielle. C’est sur le modèle du transformeur que reposent Google BERT ou GPT-3 de OpenAI. Ce modèle est de plus en plus utilisé dans les domaines autour de la traduction, de l’analyse d’image ou encore de la recherche en santé.

L’intégration du Transformer Engine doit permettre, selon Nvidia, d’accélérer jusqu’à 6x les réseaux de neurones artificiels face à l’ancienne génération.

Nvidia a proposé plusieurs comparaisons de performances entre la nouvelle génération H100 et la puce Ampere A100. Avec la mise à l'échelle de GPU en série, Nvidia promet une multiplication des performances allant jusqu'à neuf, passant le délai d'entraînement de 7 jours à seulement 20 heures.

Lancement au 3e trimestre

Nvidia Hopper sera disponible pour les professionnels à partir du 3e trimestre. La firme a déjà signé avec des partenaires de premier plan du secteur comme Dell, Fujistsu, Supermicro, Cisco, Atos ou encore Hewlett Packard Enterprise, pour proposer des produits propulsés par H100.