Problème endémique sur le net, les commentaires ouvertement hostiles, irrespectueux voire carrément toxiques sont légions. Parmi les premiers concernés par ce fléau, YouTube a annoncé le déploiement progressif de plusieurs fonctionnalités ayant un double objectif : dissuader les haters de poster leurs commentaires haineux, mais aussi protéger les vidéastes en proposant un filtre de modération destiné à leur éviter la lecture de ce type de contenus.

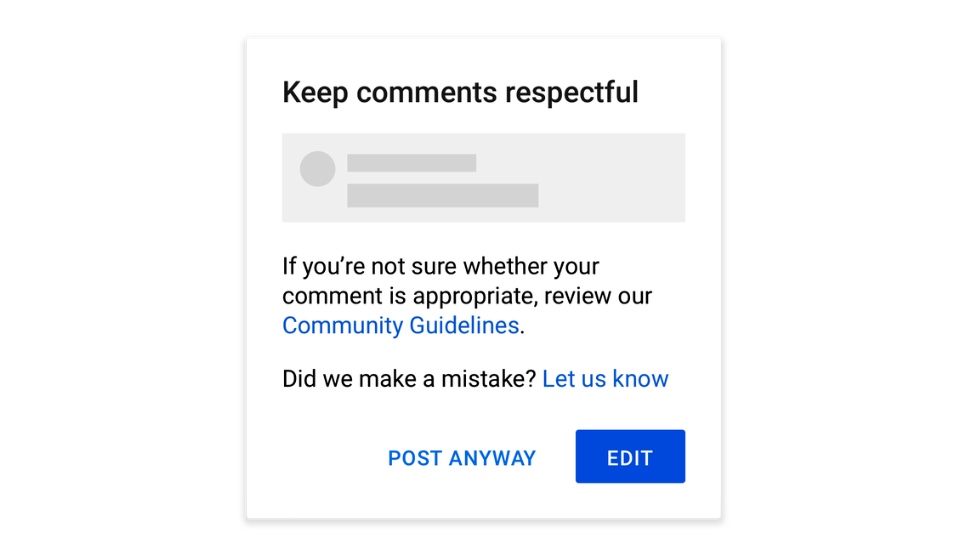

YouTube prévoit aussi de mener en 2021 une enquête auprès des créateurs pour récolter des données qui viseront à déterminer pourquoi certains vidéastes sont plus concernés par la haine en ligne et le harcèlement. La principale nouveauté reste néanmoins l’apparition sur la plateforme d’un message d’avertissement lorsqu’un utilisateur s’apprêtera à publier un commentaire offensant. Il lui sera alors possible de consulter le règlement de la communauté, de modifier son commentaire (au travers d’un bouton bien en évidence)… ou de le partager quand même.

Haine en ligne : YouTube prend le problème à bras le corps (ou en tout cas essaye)

Avec cette alerte, YouTube veut avant tout se montrer dissuasif en ajoutant un obstacle à la publication d’un commentaire susceptible d’être haineux. L’idée est vaguement reprise d’Instagram qui a mis en place un système similaire l’année dernière. La plateforme a depuis indiqué que cette méthode avait aidé à réduire le harcèlement dans les commentaires, sans toutefois fournir de données précises. Comme le rapporte TechCrunch, ce type de mesures arrive tardivement sur les réseaux. Car si elles peuvent effectivement dissuader la publication de commentaires déplacés, et contribuer à réduire le harcèlement, elles induisent aussi une éventuelle baisse du taux d’engagement pour les plateformes. Un problème redouté par YouTube, Instagram et bien d’autres.

Dans le cas de YouTube, le système d’alerte sera basé sur des algorithmes capable d’apprendre quels types de commentaires sont irrespectueux en analysant ceux qui sont le plus souvent signalés par les utilisateurs. IA oblige, ce système se perfectionnera avec le temps.

En parallèle, YouTube compte aussi proposer un filtre aux vidéastes pour leur épargner la lecture de contenus haineux. Ce dernier sera proposé par l’intermédiaire de l’outil de gestion de chaîne YouTube Studio. Une fois actif, ce filtre cachera les commentaires blessants ayant été préalablement signalés. Jusqu’à présent, la modération des commentaires requiert dans certains cas l’intervention des vidéastes eux-mêmes, qui se trouvent alors confrontés à des messages potentiellement choquants. YouTube veut éviter cela.

Ces mesures seront complétées, promet le service, par une réorganisation de son processus de modération afin de rendre plus rapide et efficace le traitement des commentaires signalés. La plateforme explique avoir multiplié par 46 le nombre de suppression de commentaires haineux depuis 2019. On apprend en outre que sur le dernier trimestre plus de 1,8 millions de chaînes ont été suspendues. 54 000 d’entre elles pour des discours de haine.

Chaque matin, WhatsApp s’anime avec les dernières nouvelles tech. Rejoignez notre canal Frandroid pour ne rien manquer !

Bientôt ils vont mettre de la pub dans chaque video, plus aucun plaisir d'aller sur cette plateforme ...

Faut pas rire 🤣🤣🤣🤣. Plus sérieusement, les chaînes YouTube encore libres ne vont pas disparaître, bientôt, si ?

Et nous, on peut avoir un filtre pour nous empêcher de voir des youtubeur toxique ?

Oh non, on pourra plus insulter squezi ?

Faut pas être de mauvaise foi non plus... C'est quand même la jungle, il y a un paquet de gens qui se cachent derrière leur écran, ils seraient dans la même situation en face à face que ce serait tout de suite beaucoup plus respectueux. Bon après il ne faut pas tomber dans l'excès inverse non plus, où le moindre désaccord serait perçu par l'algorithme comme "toxique".

Bien sur qu'une personne peut être mauvaise pour l'organisme o_O. Ce n'est même pas une question qui devrait être posé, tellement c'est logique

Une personne peut etre mauvaise pour l'organisme ? Je savais pas, du coup c'est reconnu par la médecine ou c'est une c*nnerie relayé par la population de plus en plus fragile ?

Un commentaire toxique ? Qu'est-ce ? Une substance toxique est quelque chose de mauvais pour l'organisme ? Quel rapport avec des commentaires ?

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et .

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.