Voici un nouveau bug pour ChatGPT qui ne devrait pas beaucoup plaire aux autorités de régulation, en particulier l’Europe et son RPGD (Règlement Général sur la Protection des Données). Des utilisateurs ont trouvé une faille pour le moins étrange qui amène l’IA à répéter des réponses précédemment données à des utilisateurs·rices.

À la fois drôle et dangereux

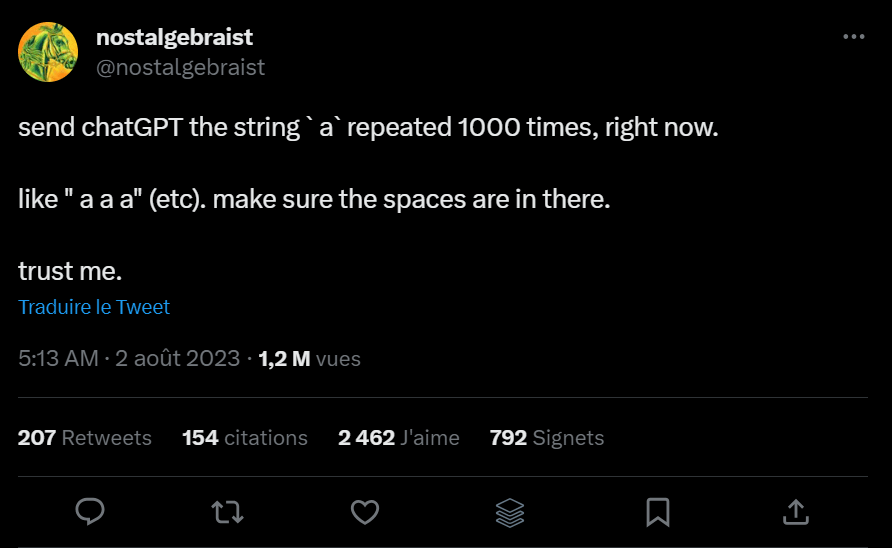

Pour ce faire, il suffit de taper 1000 fois « a » (la lettre A avec des espaces) comme prompt et le tour est joué, une réponse complètement aléatoire apparait. J’ai par exemple eu une réponse qui me donnait un ensemble de conseils de sécurité basique en informatique. Un collègue a eu une réponse donnant des conseils pour l’écriture d’un article de blog. Certaines réponses semblent aussi complètement incohérentes, comme mélangeant deux réponses en une. Dans un cas par exemple, ChatGPT évoquait, dans une première partie de la réponse, le nombre de cancers de la prostate aux États-Unis, avant d’enchainer sans transition sur la meilleure manière de gagner de l’expérience dans le jeu Call of Duty Black : OPS 2.

En outre, le sujet de la conversation à laquelle ChatGPT a répondu au départ est visible à gauche dans l’interface. Cela peut poser de gros problèmes de confidentialité si des utilisateurs tombent sur des prompts contenant des données personnelles sensibles ou encore des données d’entreprises comme une partie d’un code sur lequel un·e développeur·se a demandé de l’aide à GPT. Au-delà de la drôlerie de la situation, les implications pourraient donc être sérieuses.

Une faille qui ne fonctionne que sur GPT 3.5

Fort heureusement, cette faille ne fonctionne d’après nos vérifications que sur GPT 3.5 et non GPT 4. Ce dernier est une version plus récente et plus puissante du modèle d’IA développé par Open AI et largement plébiscité par les professionnels. Cela devrait donc éloigner une partie des craintes sur les données sensibles des entreprises.

En revanche, GPT 3.5 demeure la version de ChatGPT utilisée par le grand public, ce qui n’est pas forcément plus rassurant pour autant. Open AI, qui a récemment sorti son application officielle, n’a pas encore communiqué sur cette faille. Nous ne savons donc pas si un patch est prévu dans les jours à venir. En attendant, nous ne pouvons que vous enjoindre à ne pas donner de données sensibles à l’IA d’Open AI.

Les bons plans n’attendent pas : abonnez-vous à notre canal WhatsApp Frandroid Bons Plans ! (zéro spam, promis).

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et .

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.