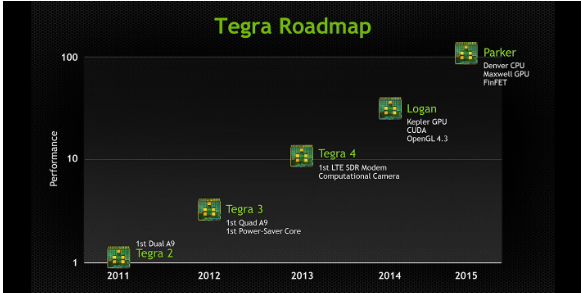

Alors que l’on avait déjà mis la main sur quelques brèves informations en rapport direct avec la nouvelle et cinquième génération d’architecture mobile de Nvidia, il semblerait bien que de nouvelles informations aient finalement fini par éclore sur le Tegra 5. Le processeur est également connu sous le nom de code de Logan (ou Wolverine, l’un des super-héros de l’univers de Marvel).

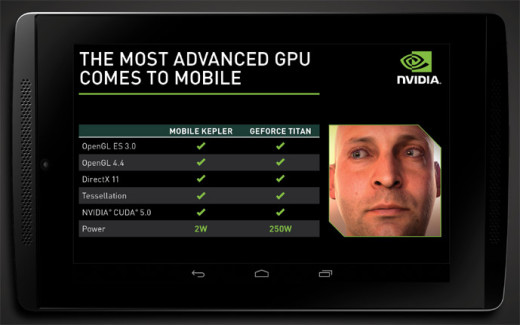

Depuis plusieurs années maintenant, on a pu constater que Nvidia avait pris goût à affubler ses architectures mobiles de noms de super-héros. Souvenez-vous, le Tegra 3 portait le nom de code de Kal-El (Superman), le Tegra 4 était quant à elle dénommée Wayne (Batman), et maintenant le Tegra 5 avec Logan (un des célèbres super-héros de la bande des X-Men). À en croire de nouvelles informations dévoilées par Jen-Hsun Huang, PDG de Nvidia, le Tegra 5 bénéficiera d’un sous-système graphique basé sur l’architecture actuelle Kepler, introduisant pour la première fois une puce graphique (GPU) avec un des shaders unifiés, c’est-à-dire avec des vertex et des pixels qui ne sont plus distincts. Une nouvelle solution qui permettra au Tegra 5 de fournir des performances graphiques jamais vues auparavant sur les appareils ultra-mobiles de types mobiles et tablettes.

La vidéo présentée ci-dessus a été réalisée en septembre à l’IFA de Berlin.

Pour se plonger plus en détails sur les capacités techniques de cette dernière génération de Tegra, le fondeur américain basé à Santa Clara a confirmé que la puce graphique installée dans son Tegra 5 supporterait 192 cœurs CUDA. Concrètement, le GPU qui est installé dans cette cette cinquième mouture d’architectures mobiles signée NVIDIA offrirait des performances qui viennent semblable à ce que l’on retrouve sur des ordinateurs portables équipés de GPU de la série GeForce 600 (GT600m). En plus de cela, Nvidia promet une consommation énergétique encore réduite grâce à une gravure bien plus fine en 20 nanomètres, et devant la précédente génération de Tegra 4 gravée en 28 nm.

Logan pourrait être formé sur une architecture ARM Cortex-A50 (Cortex-A53 et Cortex-A57) lui conférant la compatibilité 64 bits. Nvidia s’est bien gardé de le dire, mais l’évocation d’une telle architecture nous laisse tout de suite penser à l’adoption et l’implémentation de la technologie big.LITTLE. D’un côté, nous devrions avoir un processeur quadri-cœur en Cortex-A57 dédié aux tâches lourdes (jeux vidéos, web, vidéos en haute définition, etc.), tandis que le second processeur quadri-cœur en Cortex-A53 devrait quant à lui gérer les tâches à plus faibles consommation énergétique (notifications en push, apps en arrière-plan, vidéo non-HD, musique, etc.), mais sera-t-elle capable de faire tourner les 8 cœurs en simultané ?

Enfin, Nvidia a conclu sur le fait que le Tegra 5 serait compatible avec Android et logiquement aussi avec Windows 8.1 RT. Nous devrions en découvrir plus lors du CES et MWC qui se dérouleront en janvier et février 2014, pour une sortie attendue au premier semestre 2014, sauf retard rencontré par la firme. Comme la tradition annuelle le veut, ASUS a d’ores et déjà commencé à faire son petit teasing saisonnier en nous présentant une Statue de la Liberté animée avec deux tablettes en main. ASUS ne devrait pas être le seul à présenter des terminaux équipés du Tegra 5, il se murmure que Lenovo, ZTE et Xiaomi seraient également de la partie ! Attendons de voir si Nvidia proposera ses GPU aux autres constructeurs pour les intégrer dans leurs architectures, à l’instar des solutions portables et bureautiques (Intel/Nvidia). Reste à voir si la déclinaison milieu de gamme du Tegra 4i sera ou non aussi au rendez-vous comme prévu.

https://www.youtube.com/watch?v=1frsVBzJVdM

Rejoignez-nous de 17 à 19h, un mercredi sur deux, pour l’émission UNLOCK produite par Frandroid et Numerama ! Actus tech, interviews, astuces et analyses… On se retrouve en direct sur Twitch ou en rediffusion sur YouTube !

c'est hallucinant le niveau de détails que cette puce est capable d'afficher, l'A7 de l'<a href="http://www.ipadmini2.fr/">ipad mini 2</a> ,n'est rien à coté de ce monstre de puissance

Je viens de poster un commentaire pour le dire mon chou, apprend à lire

Le gain sans recompilation (pour en particulier profiter des nouvelles instructions) est en effet minime. Le gain après recompilation, dépend du type l'appli, mais comme le dit ReiverBlade, n'est pas forcément super visible pour une appli lambda. Pour iOS le passage au 64bit sera surement assez rapide en fait: - Apple contrôle le soft et le hard, donc peut proposer du jour au lendemain à que du matos 64bit - Apple contrôle le store et donc pourra forcer les développeurs à livrer des app 32 et 64bit (déjà Apple force à ce que toutes les applis soient ios7 compliant) Ca ne fera pas comme avec Windows, qui doit se trainer des procs 32 et 64bit même encore aujourd'hui. Pour Android ca risque de faire pareil que pour Windows, pour les même raisons... diversité des hardwares, diversité des versions d'OS.

Merci de ta réponse mais c'est une 8" seulement.

Merci je regarde les test tout de suite

Non car ma GTX 580 fais encore presque tout tournée largement sur un seul écran en full hd et presque tout au max donc 2 780 a part si tu joue en triple screen je trouve ça ridicule et jeter de l'argent par la fenêtre ^^

il n'ya malheureusement pas grand chose de bon en 10 pouces Tegra 4 , les Toshiba Excite sont à proscrire mauvais choix de composant , la tablette peine un comble avec du Tegra 4 , La HP Slate 8 Pro est un bon compromis pour l'instant et en promo 319€ jusque demain !!! http://h20386.www2.hp.com/FranceStore/Merch/Product.aspx?id=F4X08EA&opt=ABF&sel=PCNB

Merci pour tes précisions pertinentes, j'ajouterais que les tegra notes sons le top des 7" (pour moi), et j'aimerais bien m'acheter la même en 10" (parce que je veux pas attendre 2015 pour le tegra 5 hein), tu aurais des infos ? Pour le remplacement de mon encombrant pc winDobe 8, par une tablette puissante et 4G (pour remplacer ma grosse chère et lente box adsl) j'en rêve depuis des années; mais le problème actuel c'est que les tablettes ne déconnectent pas la batterie, quant le courant secteur est branché,et donc elle est vite flinguée, quelqu'un connaîtrais la solution svp?

J'ai toujours mon One X et il envoit toujours du paté, d'autant plus depuis les nombreuses mises à jour de HTC, avec Android 4.3 et Sense 5.0, ce téléphone est un vrai plaisir à utiliser. Les Tegra 3 et 4 ont une mauvaise image pour les mauvaises raisons.

moi j avait un one x avec tegra 3 qui était hyper rapide et qui chauffait pas plus que mon one sou snapdragon ! je trouve malgré les benchmark faut car mon tegra 3 était et et toujours bien plus véloce que mon s6oo très déçu de snapdragon vivement un tegra 5 moi j ai goute au deux et il y a pas photo Téhéran et nettement plus fluide et chauffe pas plus ni consomme plus du marketing simplement pour snapdragon non fini prendrai que du tegra maintenant ! et les jeux nul en snapdragon toujours des ralenti au bout de 3o minute ça chaufe et le CPU GPU doivent sûrement baisse de rythme très décevant !<i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

ARM à toujours eu cette place dans les TV et autres trucs qui avaient de l électronique embarquée. Si les fabriquant utilisent leur propre design, ils ne payent pas pour utiliser le design de ARM, autant pour la partie CPU (qui est de moins en moins utilisé) que pour la partie GPU (qui n'est quasiment plus utilisé (mali). Alors oui le jeu d'instruction ARM prend clairement de l'importance, mais d'un point de vue economique ARM ne s'impose pas sur tout les fronts. De plus malgré que ARM gagne du terrain sur certain domaine (serveur par exemple et ordinateur low power) Intel n'a pas dit son dernier mot et compte bien récupérer ce qui est sien et même prendre des parts de marché sur le mobile. Bref tout ça pour dire que l'avenir pour ARM n'est pas SI brillant que ça. Leur position est confortablement assise grace à l'adoption massive de leur jeu d'instruction mais en dehors de ça c'est pas si radieux. Samsung a essayé de resté sur un design ARM avec l Exynos Octa, le moins qu'on peut dire c'est que c'est pas une réussite, et encore ils utilisaient pas le GPU Mali.

Pourtant le design ARM s'est impossé dans les tablettes et smartphones , ca arrive dans les TV, serveurs , la fin du monopole X86 d'intel qui a asphyxié le PowerPc et d'autres technologies prometteuses , même l'outsider AMD est convaincu de l'avenir de l'ARM proposant des Hybrides entre les deux mondes http://www.amd.com/us/press-releases/Pages/press-release-2012Oct29.aspx , on devrait voir apparaitre des solutions ARM 100% en 2015 ou 2016 Si les trafiquants proposent des design" maison" c'est parce ARM est une architecture tolérante, wikipedia pour unje fois (lol) résume bien la situation http://fr.wikipedia.org/wiki/Architecture_ARM

Mince personne a vu mon pseudo...

Dans la mesure ou chaque acteur se dirige vers leur design custom (apple cyclone, qualcomm krait, nvidia Denver...) je me demande si l'avenir s'annonce ci prometteur que ça pour ARM. Alors ok ils licencient les set d'instruction ARM mais en dehors de ça y'a pas grand grand chose... Les design made in ARM on l'air d'avoir du mal a convaincre durablement les fabriquant ou alors ils sont très peu intéressant economiquement pour que chacun d'entres eux se tournent vers leur propre solution.

Ouais, apple est fort en marketing. Les architectures 64 bits sont prévues pour arriver sur le marché début 2014, ça fait 2 ans qu'on le sait. Apple a juste joué la bonne carte, sortir un proco 64 bits avant tout le monde. Avaient-ils le choix ? Non. Un seul modèle par an. Ils se seraient retrouvés en mauvaise position s'ils avaient attendu. Oui, le 64 bits est une nécessité. Mais, contrairement à ce qui a été annoncé par les marketeux, le passage au 64 bits ne s'est pas fait en un claquement de doigt, alors qu'il a fallu 10 ans à Microsoft (et macos ;) ) pour y passer. Les applis doivent être re-développées POUR le 64 bits. Sinon, le gain est minime, non ?

Non. L'avantage du 64 bits va au-delà de la RAM. Ça joue, c'est certain; Mais regarde sur PC. Proco, OS et applications 64 bits, c'est un trio très performant. Maintenant, c'est sûr, Proco + OS 64 bits pour faire tourner majoritairement des applications 32 bits, l'intérêt est tout de suite plus limité. Un peu comme sur PC pendant des années. Quelques applis étaient codées en 64 bits, tout le reste était en 32 bits. J'en ai fait l'expérience avec... WoW. Quand le client 64 bits était dispo, j'ai tout de suite vu la différence. Les performances n'étaient pas décuplées, mais j'ai gagné quelques fps, et le jeu, chargé en RAM demandait moins d'accès disque. Je peux profiter de mes 8 Go :) Et pas que dans WoW. Client 64 bits pour Winamp, Media Player Classic, Photoshop, Power Director, etc.

Sublime !

En fait ul n'y pas eu de lenteurs avec la sortie de Tegra 4 mais le cout de production au départ etait prohibitif par rapport aux solutions low cost de Qualcomm , le Tegra 4 etant pourtant bien supérieure aux séries Snapdragon 4XX,6XX, et 8XX mais les différentes marques avaient déja remplit le carnet de commande auprès de Qualcomm ou pire Mediatek , Nvidia à poussé à la va vite son plan Marketing Tegra Note ( ou tablette Clone) mais c'était sans compter un problème de production visant la première série équipée d'un écran "problématique" , ce explique pourquoi Gigabyte et Xolo attendaient la Rev2 de Tegra Note avec cette fois un bon écran 7 pouces d'origine LG . Et oui après la valse des dalles en Tv on va vers celle des Tablettes mais dans le cas de la Tegra Note c'est possitif !!! Pour Tegra 5 & 6 c'est un bon avant avec CUDA et Direct X11 vous n'avez pas conscience mais cela changer l'avenir des tablettes qui seront des" All in one " mêlant puissance bureautique ,tabeltte graphique, Vidéo, jeux consoles (on parle d'émulateurs PS2, Gamecube et Wii ...dans une tablette dingue), pour un prix toujours inférieure , avec un cable HDMI et Clavier sans fil votre tablette sera votre PC de bureau . L'avenir s'annonce prometteur pour ARM

Je ne serais pas si catégorique. Ils ont une base solide de clients qui se contentent de la puissance offerte, et qui est suffisante pour faire tourner correctement leurs machines. Ce sont deux philosophies qui s'affrontent. D'un côté, la puissance brute, de l'autre, le "minimum social". Il faut reconnaître que l'association d'un A7 et d'un M7 (qui s'occupe des capteurs uniquement), est efficace.

Il me répondait, en fait :)

c est pour fin janvier chez nous et il y a déjà des smartphones qui sortent en ce moment avec Tegra 4i en Asie

Tu as a un regard "purement" théorique sur l'architecture 64bit, sans regarder les détails d'implémentations de l'OS ou du runtime. Dans le cas d'Apple, le 64bit permet par exemple, une augmentation des perf de la gestion mémoire car au lieu de gérer les références des pointeurs dans des tables séparées, une partie des 64bits d'un pointeur est utilisée pour enregistrer ces même données. Ce gain de perf est indépendant des améliorations de l'archi, mais il n'est pas de 10%, par contre. Lorsque l'autre zigouigoui nous dit que le passage au 64bits chez Apple est juste bidon, c'est son commentaire qui est bidon. Le passage au 64bit est une nécessité pour le future... Apple prépare le terrain, car ca prendra du temps, et Android devra le faire tot ou tard et le plutôt sera le mieux. Et puis c'est un beau coups marketing et pour faire chier les autres (et ca marche très bien)

Tout a fait, en 2013 ils ont prient leur reve pour la realitee, j'espere qu'il vons ce rattraper pour 2014, parceque maintenant on ce retrouve en haut de gamme avec le monopole de Qualcom.

Les snapdragon chauffent bien moins que les tegra 3, 4 justement, c'est aussi pour cela qu'ils ont été préféré et le tegra 4 a eu autant de mal a sortir en nombre. Pourtant le tegra 4 est nettement moins cadencé que le snapdragon 800 même si il est aussi performant,c'est vrai.

Je répondais a ceci : "Je connais surtout nVidia sur PC. Je ne savais pas qu'nVidia était mauvais élève" Dommage.

Nvidia est mauvais élève dans ses tegra, je ne parle nullement de ses cartes graphiques gt700 ni gt600 ni gt700m et gt600m qui n'ont rien avoir et peuvent se permettre de dégagement nettement plus en watt. Ici on est limité a 2 Watt maximum donc rien avoir, et ici nvidia n'est plus a la fête, a ne pas confondre. Mais je pense qu'on serait loin d'une gt630m, on n'en sera loin car c'est clairement impossible avec 2 watt.

Tu compare un sli de gtx780 avec un tegra 5 qui doit consommer 2W, super, n'importe quoi même si j'ai bien compris ou tu voulais en venir. Mais ici on parle de soc arm avec partie graphique intégré dedans qui n'a rien avoir avec les cartes graphiques dont tu parle. Le refroidissement sur les tegra 3 et tegra 4 n'est nullement maitriser, a ne pas confondre donc.

et pourtant c'est souvent démontré que un executable 64bit est pas plus rapide que son équivalent 32bit enfin pas visiblement pour l'utilisateur de base. (2-20% surtout si c'est plus souvent 2 que 20 :) ) Il ya deux raisons pour adopter une architecture 64 bits. Premièrement, il ya adressage RAM, Les systèmes 32 bits sont limités à 4 Go de RAM en théorie et généralement 2-3Go pour une seule application en fonction des paramètres du système d'exploitation. Les systèmes d'exploitation 64 bits permettent jusqu'à 16 exaoctets de mémoire. La pression pour déplacer des CPU ARM pour les architectures 64 bits a été discutée presque entièrement en termes de serveurs, car c'est là que les avantages réels à la mémoire d'adressage sont. la deuxième raison du passage à une architecture 64 bits - entreprises les utilisent souvent comme une excuse pour nettoyer tous les cochonneries et les déchets laissés dans une mise en œuvre préalable d'une puce 32 bits. effectivement les codage et registres ont leurs avantages ensuite le gain en général, vous pouvez vous attendre un gain de performance de 2-20% de la simple recompilation d'un programme - ce qui s'explique par des changements d'architecture des processeurs 64 bits donc oui tu as raison (mis a part que le 64bit as d'abord été déveloper pour l'adressage RAM a la base) c'est plus rapide mais sur L'iPhone 5S par rapport au 5 c'est pas le passage au 64bit qui le rend plus rapide

Beau hors sujet. Vain mais très instructif. On a compris qu'on peut dépasser 4Go de RAM en 32bits... mais on s'en fout. Mon exécutable optimise et compile pour du 64bits, il va plus vite que son équivalent en 32. La quantité Max de RAM, on s'en tamponne.

tiens ca c'est amusant: http://www.extremetech.com/gaming/166244-iphone-5s-the-64-bit-a7-chip-is-marketing-fluff-and-wont-improve-performance Don’t be fooled None of this means the A7 won’t be faster than A6, but it does mean that the 64-bit status of the A7 is a marketing tool, not a genuine performance boost. The major reasons for adopting 64-bit architectures simply aren’t present in mobile devices. It’s not clear that a phone with 4-8GB of RAM ever makes sense given current constraints on battery life. The blend of 64- and 32-bit software means the A7 will offer strong performance in both categories (good), but won’t automatically have a clear benefit from doing so until the entire application stack has switched over. That’s not going to happen for years yet, given that iOS7 supports all iPhones going back to iPhone 4. enfin si on as des notions de base en Anglais ...

les bases oui demande a un utilisateur lambda les avantages du 64bit. effectivement il vas te reciter les bases Sans EAP, ni PSE (en), les processeurs 32 bits ne peuvent pas adresser plus de 4 gibioctets (232) de mémoire centrale, tandis que les processeurs 64 bits peuvent adresser 16 exbioctets (264) de mémoire. C'est pourquoi dès qu'il y a plus de 4 gibioctets sur une machine, la mémoire au-delà de 4 gibioctets ne sera utilisable qu'en 64 bits. Avec les systèmes Windows 32 bits, seuls 2 gibioctets sont disponibles pour les processus utilisateur, le reste est réservé pour le noyau. Il est cependant possible de faire passer la mémoire utilisable par les processus utilisateur à 3 gibioctets en modifiant le fichier boot.ini. Le mode EAP permet pour un système 32 bits d'étendre l'accès à la mémoire physique jusqu'à 36 bits en utilisant un système de pagination pris en charge par le processeur (PAE). Ce système peut augmenter la quantité maximum de mémoire vue par chaque application Windows 32 bits normalement limitée à 3 gibioctets en utilisant conjointement Address Windowing Extensions (AWE). Il permet également d'adresser la mémoire physique jusqu'à 64 gibioctets et de servir plusieurs applications non compatibles AWE à concurrence de 3 gibioctets par application. Windows XP a été compatible EAP jusqu'au service pack 1, puis le support d'EAP pour l'extension mémoire a été abandonné. Le mode EAP sur ce système peut toutefois rester actif mais uniquement pour permettre l'utilisation du mode prévention d'exécution des données (DEP). Windows 7 32 bits version pro ou intégrale ne supporte pas l'extension mémoire par EAP et ne reconnait donc qu'un maximum de 3,25 gibioctets de mémoire physique. EAP nécessite une modification du noyau (licence spécifique requise) ou une version serveur du système pour fonctionner. Le noyau Linux supporte totalement EAP depuis la version 2.3.23 (octobre 1999) sans restrictions de quantité mémoire (supporte jusqu'à 64 gibioctets). EAP permet de prolonger la durée de vie des environnements 32 bits lorsque le passage aux systèmes 64 bits n'est pas possible pour des raisons de compatibilité (drivers et applicatifs non pris en charge). En 64 bits, les entiers et les adresses passent de 32 bits (4 octets) à 64 bits (8 octets). Mais dans le cas de l'architecture x86 ce n'est pas l'unique changement. Les processeurs x86 32 bits actuels (Celeron, Pentium, Pentium II, Pentium III, Pentium 4 jusqu'au Prescott) sont en fait des processeurs 8-bits (l'Intel 8088) améliorés pour faire du 16-bits, et à nouveau améliorés pour faire du 32-bits. La structure des registres dans un processeur x86 32 bits hérite donc de ce passé tant dans le nombre réduit de registres que dans leur structure archaïque. Passer de x8632 bits à x86 64 bits permet de passer de 8 registres généraux 32 bits à 16 registres généraux 64 bits. Ceci ne vaut que pour l'architecture x86, les autres architectures qui existent en 32 bits et 64 bits (MIPS, SPARC, PowerPC...) n'ont pas leur version 32 bits encombrée d'une structure archaïque.

NVidia est victime du Cortex A15 comme Samsung : une architecture qui consomme beaucoup trop pour aller dans les téléphones.

Mais non. Y a pas besoin de dépasser 4Go de RAM pour profiter des capacités de traitement un proc 64bits. Tu n'as pas l'air d'avoir compris les bases de l'informatique toi.

TOUS les SoCs ARM modernes throttlent. TOUS.

sur iPhone le A7 64bit c'est juste bidon : 1go RAM ... maintenant les smartphones Android on plus souvent 2go ou 3go (Note 3 entre autre) et 3-4go c'est la limite du 32 bit, donc par définition les smartphones Android sont plus proche d'avoir une réel utilité du mode d' adressage mémoire 64 bit que un iPhone 5s <i>-------<a href="https://play.google.com/store/apps/details?id=com.frandroid.app">Envoyé depuis l'application FrAndroid pour smartphone</a></i>

Et dire que la Tegra 4 était sensée devancer les Qualcomm ! Maintenant la nouvelle génération des Snapdragon commence à pointer le bout de son nez, toujours pas de Tegra 4 sur smartphone...

Quelle perspicacité ! Tu as tout compris, mais alors, vraiment TOUT COMPRIS ! Bravo champion !

Du Tegra 5 avec cortex A57 & 20nm ? moi je pense que c'est possible, mais on l'aurait pas avant 2015 ou pire, vu la lenteur qu'il ont eut avec le tegra 4, mais j'espère me tromper.

3 + 1 tablette graphique (Wacom 22").

Je ne comprends pas. Quand Apple a lancé son A7 en 64bit, c'était de la merde, mais là, cu que c'est pour les smartphones Android, c'est bien ?

0_o

Vive le Mediatek M6595 !

Et avec ton sli de 780 tu as minimum 3 écran?

Jerry Golay...

Comme on me l'a dit, ce n'est qu'une estimation. Mais sincèrement, je pense que l'on se rapprochera beaucoup plus des GT 610M/620M, et encore cela reste assez haut en terme de perf. sur mobile. Après, s'ils arrivent à aller au-delà, je tire mon chapeau car cela sera clairement une prouesse technique. Reste à voir ce que nous réservent les CES /MWC du début de 2014. ;-)

Nvidia ces largement rattraper.. J'avais un sli de GTX 470 une chauffe et un bouquant pas possible depuis j'ai un slide GTX 780 super bien refroidis, quasi inaudible. Ils ont appris de leurs erreur ces le but non ?

...

Exit l'aluminium, maintenant c'est l'adamantium

le jour ou tu fais tourner bioshock infinite en elevé de manière correcte sur un portable entré de gamme tu m'appeles aussi. Il a raison de dire que c'est plus SI vaste. Y'a encore un écart mais il se réduit d'année en année.

XD hahahaha , non mais serieux HA HA HA HA , bande de vieux geeks quoi, la carte coute 50e , un tegra ca en coute 8 , meme si la puissance delivrée etait la meme yaurais eu tellement de recherche pour miniaturisé et baisser la chaleur (je vous dit pas le bordel sur mon pc ) que le prix serais juste delirant , ou alors ok, c'est comparable et ca coute 4000e, et c'est a la pointe de la technologie ... bref, le jour ou on feras tourner bioshock infinite en elevé sur une tablette avec un tegra 5 vous m'appeler

ben non, l'écart n'est plus si vaste entre les archi de pc portables et tablette/smartphone...

va te pendre avant d'acheter cette merde

C'est une blague ? la gt630m est dans mon ordi a 700e ... revez les gens revez

Quelles sources sures ?? parce que sinon c'est juste du pipeau et on continue avec le A15 et non A57 ...

windows 8.1 RT est la version pour les soc ARM .. donc ici le tegra 5 sera compatible avec Windows 8.1 version RT, il n'y a meme pas de question à se poser ... tout comme le tegra 4 sur la Surface 2

D'accord, les infos viennent donc d'une autre source non évoquée. Bon bon... On verra alors :)

Vivement que le nouvel Exynos sorte qu'il remette de l'ordre dans tout ça!

La compatibilité 64 bits sur Tegra 5 m'a été confirmée de sources sûres. De là, on peut supposer que le Cortex-A50 sera de mise (dont on peut également supposer par la même occasion à l'adoption d'une archi big.LITTLE). Je doute fortement que Nvidia se contente uniquement et encore du Cortex-A15 en 2014. De toute manière, nous verrons bien lors des évènements du CES et du MWC en janvier et février 2014 prochains.

Merci, j'ai effectivement suivit la chaine de source à la fin de votre article pour atterrir sur cet article chinois. Avec un petit coup de google traduction j'ai vaguement pu apercevoir de quoi il s'agissait mais a aucun moment il n'y a eu mention de Cortex A57 ou 20nanometre. Je vois juste les mêmes infos que celles annoncées y'a presque un an par Nvidia. D'où vient une tellement différence d'informations entre cette source et votre article ?

À cette adresse : http://www.padnews.cn/?p=4891

Je ne connais pas assez nVidia (en SoC mobile) pour te contredire ;) J'avance des arguments avec mes lectures, sans expérience personnelle. Je connais surtout nVidia sur PC. Je ne savais pas qu'nVidia était mauvais élève ;)

J'aimerai vraiment savoir d'où sortent ces informations. Parce que déjà on contredit tout ce qui à été annoncé jusqu'alors sur le T5 (architecture CPU etc) et je peine encore à voir quelles informations nouvelles réelles sont présente dans cet article ? A part la vidéo teaser de Asus qui n'a strictement rien a voir avec ça (certainement un device dual boot windows / android ) tout les éléments sont de vieux slides de nvidia. Parce que, honnêtement, tout cela ne m'a pas l'air très crédible. Jusqu'à nouvel ordre nvidia tablait sur une architecture quad A15 avec leur propre companion core, et gardant la même finesse de gravure (28nm). Etant eux même en train de développer leur propre architecture CPU (Denver) en 64 bits pour Tegra 6 j'ai du mal à croire qu'ils investissent dans une architecture Cortex-A57 avec big.little, jetant au passage leur architecture 4+1, juste pour une seule génération (le T5) qui sera complètement jeté à son tour pour Denver dans le T6. Le focus de Nvidia sur son T5 est sur le GPU, ils ont une architecture qui est designé pour du 28nm, quand bien même ils auraient des usines en 20nm a disposition (ce qui n'est certainement pas le cas, a regarder le paysage des fondeurs actuel) je ne pense pas qu'ils en tireraient partie sur cette génération. Ils ont annoncé utiliser la gravure FinFet (14nm) pour Tegra 6 qui utilisera une nouvelle architecture CPU et GPU (maxwell) prévu pour être produite en 14nm, je doute qu'ils investissent dans une gravure en 20nm juste pour le T5. Bref tout ces points me rendent très sceptique quand aux informations annoncé dans cet articles et je me demande VRAIMENT d'où sort tout ce machin et si ça a vraiment un fondement. A moins que ce ne soit juste l'occasion de faire rager les anti/fan Nvidia histoire de faire du clic ? Nan je suis médisant evidement.

Tegra 5 & Tegra 6 seront des pas de Geants pour l'Architecture ARM , puissance phénoménale et support de CUDA , voila qui va enterrer un peu plus l'Ipad , lentement Apple va rejoindre son créateur et rejoindre dans quelques années Commodore, Atari, et autre Archimede , c'est décidé je vend mes actions Apple pour acheter du Nvidia :)

"Android et Windows 8.1 en version standard, sans rien préciser sur la version RT." Windows 8.1 gère l'ARM ??? Ce ne serait pas plutôt Windows Phone 8.1, qui semble être la fusion entre Windows RT et Windows Phone 8 ??? D'où une réponse à l'interogation précédente...

en quoi Nvidia est il mauvais ? Jusqu'à preuve du contraire ce ne sont pas les SoC Tegra qui throttle à la moindre occasion.

Pour le dégagement thermique, nvidia est mauvais a chaque fois,le tegra 3,tegra 4, même si la gravure est plus fine, donc cela ne veut strictement rien dire avec si il change d'architecture. 2W, c'est vraiment rien. Et puis le problème c'est que le tout va gérer des résolutions de jusqu’à 2K ou 1440p et la bien on va bien voir.

2013 l'année à qualcomm 2013 Tegra revient en force : intéressant mais je précise ceux qui ont pris un mobile en 2014 sera toujours puissant en 2014. Dans mon entourage il veulent toujours être au top chaque année, mais se veut rien dire...... . En Tout cas la puissance graphique d'une ps3 on y arrive! déjà avec la série S600/S800 de 2013 chez qualcomm avec un bon jeux les graphismes sont nickel ( GTA,DEAD TIGGER...) il faut que sa continue !

Je pense que la dissipation thermique et la chauffe sont maîtrisés. Gravure en 20 nm, et perfs certainement proches d'un GPU 610m (largement suffisant pour un portable ou un tablette je pense). Pour le délais, un an c'est raisonnable. A moins qu'ils ne nous aient réservé une surprise :)

Un représentant de la marque m'avait fait part d'une estimation à hauteur du GPU "GT630M", mais ces estimations ne sont pas vraiment finalisées, et ont encore besoin d'approfondissements.

Au vu que le tegra 4 vient de sortir a la vente, le tegra 5 n'est pas prêt de sortir a la vente aussi, il faudra attendre aussi fin 2014 pour les voir apparaitre dans des produit vendu dans le commerce, quoi pas demain la veille. Et puis l'architecture kepler 600, oui mais laquelle version, car d'une Gt610m a une GT650m, y a une énorme différence en performances, donc on va bien attendre avant de se dire que cela va être ultra bien. Et puis le dégagement thermique, c'est la que nvidia devrait sérieusement se pencher dessus. Et finalement comme on les résolution augmentent avec, je pense qu'on aura pas tant de différence que cela en progression de performances. A voir dans un an ou presque.

Et même si elle est dévoilée, elle ne sortira pas en janvier. Mais oui, une commercialisation au niveau mondial est à prévoir pour la Nvidia Shield 2.

est-ce que la shield 2 sera également présentée lors du ces pour une sortie mondiale ?

Neeeed !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et .

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.