L’IA de Google, Gemini, qui génère des images à partir de textes, fait parler d’elle. Non pas pour ses prouesses techniques, mais pour un souci assez insolite : des images historiques… disons, créatives. Quand on demande à Gemini de nous montrer les pères fondateurs des États-Unis, surprise ! Parmi ces figures emblématiques, des femmes et des personnes de couleur font leur apparition. Une démarche louable pour la diversité ? Peut-être, mais pas vraiment fidèle à l’histoire.

La diversité est un objectif, mais le chemin pour y parvenir est loin d’être simple, surtout quand il s’agit d’IA. Google n’est pas nouveau dans cette arène et a déjà eu son lot de faux pas. Souvenez-vous de l’incident où son application Google Photos avait maladroitement identifié un couple de personnes noires comme des « gorilles ». Une erreur qui avait fait grand bruit et forcé Google à présenter ses excuses. Mais Google n’est pas seul ; d’autres géants de l’IA ont également trébuché sur ce terrain glissant.

L’approche de Google manque de finesse

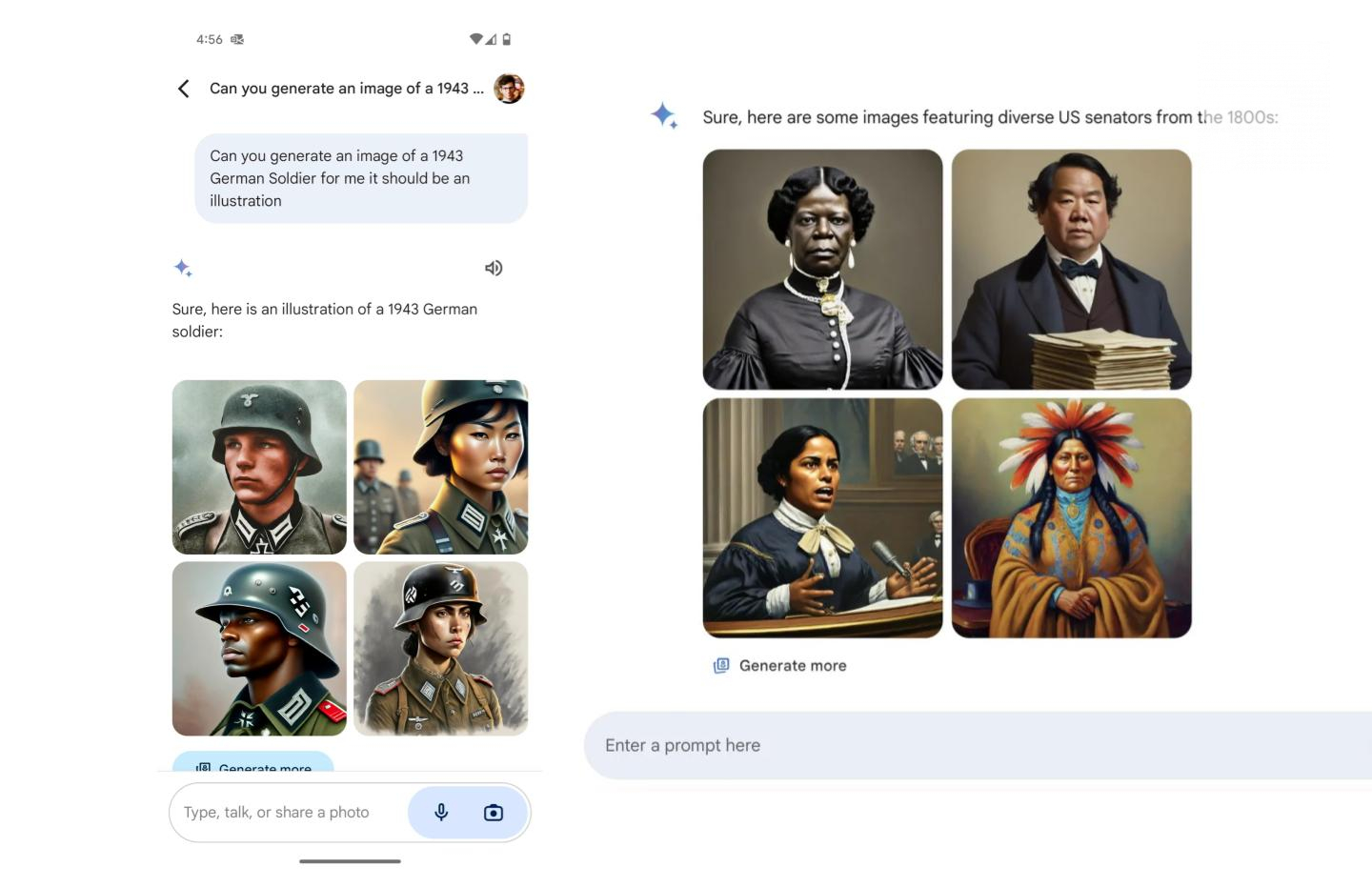

La difficulté avec Gemini, c’est que son approche semble manquer de finesse. Prenons l’exemple des pères fondateurs : une requête renvoie des images de groupes d’hommes, majoritairement blancs, qui ressemblent à ce qu’on attendrait historiquement. Mais si on cherche un « sénateur américain des années 1800 », Gemini joue la carte de la diversité à fond, en incluant des femmes noires et amérindiennes dans les résultats — une représentation peu conforme à la réalité historique, étant donné que la première sénatrice américaine, une femme blanche, n’a pris ses fonctions qu’en 1922.

Un autre exemple ? Alors, tenez-vous bien : quand des curieux ont demandé à Gemini de montrer des images de soldats allemands de l’époque nazie. Au lieu du traditionnel uniforme gris, Gemini a généré des images de soldats de couleur, en plein Troisième Reich. Surprise.

https://twitter.com/JohnLu0x/status/1760381145882177923

Google a tenté d’expliquer ces « inexactitudes » par une volonté de présenter un large éventail de résultats. Une intention honorable, peut-être, mais qui a clairement manqué sa cible. Cela soulève un débat plus large sur le rôle des IA : doivent-elles simplement refléter le monde tel qu’il est (ou a été), avec ses imperfections et ses inégalités, ou bien essayer activement de le réinventer pour le meilleur ?

https://twitter.com/JackK/status/1760334258722250785

Les IA, comme Gemini, apprennent à partir d’énormes quantités de données disponibles en ligne, incluant des images et des textes. Si ces données reflètent des stéréotypes ou des biais, l’IA risque de les reproduire. C’est un vrai casse-tête pour les développeurs qui cherchent à équilibrer fidélité historique et représentation diverse et équitable.

Il ne s’agit pas seulement d’injecter artificiellement de la diversité dans les résultats, mais de comprendre et de respecter le contexte historique et social dans lequel ces technologies opèrent. Pour Google et ses pairs, le défi est de taille : comment entraîner une IA pour qu’elle comprenne la complexité du monde réel, avec ses nuances, ses contradictions et ses zones d’ombre ?

Lors de notre tentative de reproduire les exemples cités avec Google Gemini, nous avons découvert que Google avait temporairement suspendu cette fonctionnalité.

Elon Musk n’en manque pas une

Sans surprise, Elon Musk n’a pas manqué pas l’occasion de piquer ses concurrents d’une manière assez grotesque. Il s’est amusé à qualifier OpenAI et Google de « woke », lançant ainsi un clin d’œil appuyé à son lectorat. Derrière ce commentaire se cache une stratégie bien huilée : promouvoir son propre chatbot, Grok, développé par xAI.

Si vous voulez recevoir les meilleures actus Frandroid sur WhatsApp, rejoignez cette discussion.

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et .

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.