Immanquable dans le monde de l’intelligence artificielle générative, Nvidia pourrait bientôt avoir de la concurrence. C’est en tout cas ce qu’affirme l’agence de presse Reuters, qui croit savoir qu’OpenAI serait en train de faire ses courses chez des concurrents pour améliorer ChatGPT.

Ces infidélités de la part de Sam Altman arrivent en plus à un moment où les relations entre les deux entreprises sont relativement floues, avec une petite centaine de milliards dans la balance.

Pour rendre ChatGPT plus rapide

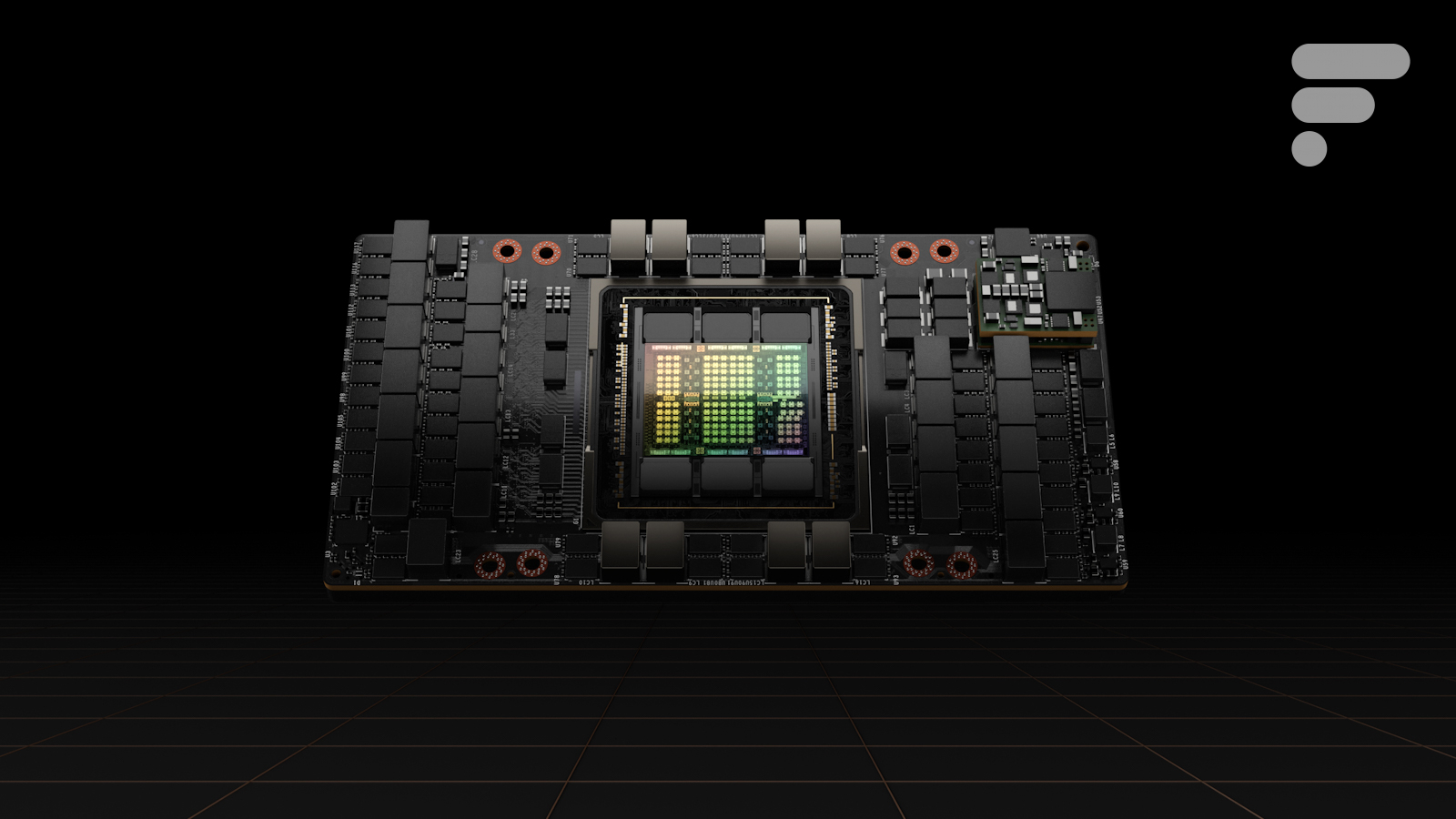

Selon plusieurs sources, OpenAI chercherait en fait des alternatives aux solutions de Nvidia depuis l’année dernière au moins. Il se murmure que les performances offertes par les cartes graphiques de Nvidia ne satisferaient pas pleinement les besoins d’OpenAI, notamment en ce qui concerne la phase d’inférence. Contrairement à la phase d’entraînement des modèles qui peut mouliner des semaines durant, l’inférence des modèles (soit leur phase d’utilisation par le grand public) se doit d’être prompte et réactive. Et selon OpenAI, les réponses offertes par ChatGPT prennent trop de temps à arriver.

Cela est particulièrement vrai pour les outils de création de code, Codex en tête. Actuellement, ces derniers se reposent sur des composants Nvidia où la mémoire RAM est dissociée du processeur, ce qui peut réduire le temps de réponse. D’autres systèmes embarquent de la mémoire vive sur le même bout de silicium que tout le reste, permettant un traitement des requêtes plus rapide. Une manière de répondre à la promesse que Sam Altman faisait il y a quelques jours de « s’investir sur les problématiques de vitesse dans la création de code ».

Tensions entre Nvidia et OpenAI

Les deux firmes en lice pour concurrencer Nvidia se nomment Cerebras et Groq. Si elles fabriquent des composants techniquement plus avancés, elles sont loin d’avoir la taille et le poids du célèbre fabricant de cartes graphiques. Comme en témoignent les projections obtenues par Reuters, OpenAI envisagerait de remplacer seulement 10 % de ses composants dédiés à l’inférence par ces systèmes plus puissants.

Pour aller plus loin

Nvidia pourrait créer une nouvelle pénurie en siphonnant des millions de téraoctets de SSD

Petit problème supplémentaire, Groq a déjà noué un partenariat avec Nvidia, qui a débauché pas mal d’ingénieurs de la firme à l’occasion. Histoire de ne pas trop vexer son partenaire historique, OpenAI, par la voix de son patron, a récemment déclaré « adorer travailler avec Nvidia » et « espérer rester un énorme client pour encore un bon moment ». On ne se défait pas de l’emprise de la plus grosse entreprise du monde comme ça.

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et .

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.