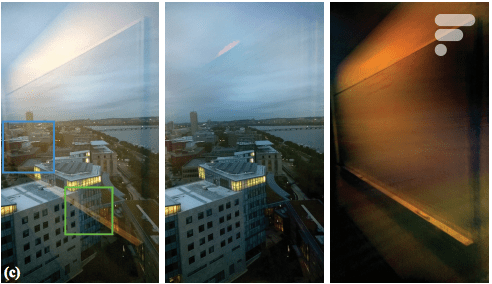

Il vous arrive souvent de prendre des photos par une vitre et d’être fortement déçu par le rendu final à cause des reflets dans la vitre ? Des chercheurs du MIT et de Google pourraient bien avoir la solution, avec un algorithme capable de supprimer les reflets d’une photo ou des objets qui cachent une partie de la scène, comme par exemple un grillage ou des gouttes d’eau sur une vitre. L’idée est assez simple et a déjà été traitée par des chercheurs ces dernières années, mais la solution qui sera présentée lors de la conférence SIGGRAPH 2015 de Los Angeles a de quoi séduire. En effet, le résultat est bluffant et la mise en place assez simple. Sur l’image de une, on peut voir la photo originale à gauche, la photo finale au milieu et à droite le reflet.

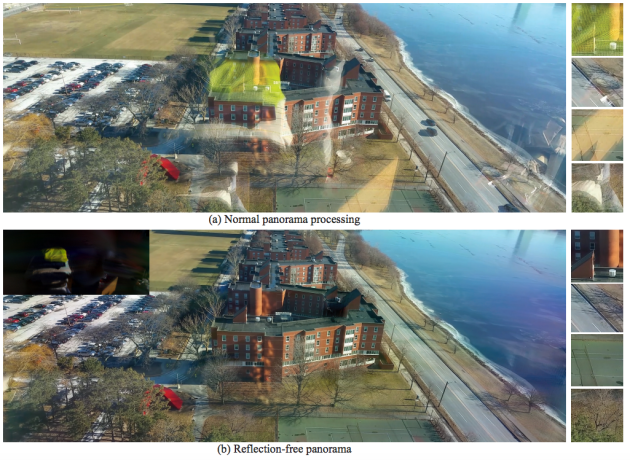

En fait, il suffit pour l’utilisateur de prendre une série de 5 à 7 photos de la scène, en bougeant légèrement l’appareil entre chaque photo, comme lors de la réalisation d’un panorama. L’algorithme compare ensuite les différentes photos et parvient à analyser la scène pour distinguer les reflets ou les objets occultant l’arrière-plan. L’algorithme propose ensuite à l’utilisateur deux photos : une qui contient uniquement les reflets ou l’objet à supprimer et une autre sur laquelle on peut distinguer clairement l’arrière-plan de manière nette, sans aucun reflet. Il est même possible de réaliser un panorama avec la même méthode.

Un algorithme encore trop gourmand pour les mobiles

Toutefois, cet algorithme magique n’est pas encore prêt à arriver sur nos smartphones. En effet, lors des tests réalisés par les chercheurs, il a fallu 2 minutes pour traiter une séquence d’images en faible définition (480 x 270 pixels) sur une application Windows Phone. Un ordinateur doté de 8 cœurs et de 64 Go de RAM a mis quant à lui 20 minutes pour traiter des images en « haute définition » de 1152 x 648 pixels. À leur décharge, les chercheurs utilisaient un code source non optimisé. Mais le traitement de photos en pleine définition de 13 à 16 mégapixels sur un smartphone semble encore loin. Dommage. Pour les plus curieux, un PDF de 11 pages permet de tout savoir sur cet algorithme.

Si vous voulez recevoir les meilleures actus Frandroid sur WhatsApp, rejoignez cette discussion.

J'imagine que le raw est conseillé quand même ;-)

GREYCstoration sur Google image et vous voyez le test du grillage avec le perroquet. Ça date de 2006

Oui je prenais Alienware en exemple parce qu'en général il ne sont pas vendu avec un Intel Celeron, pas spécialement pour la CG. Oui je parlais d'exploitable par une grande marque pour par exemple l'intégré d'origine sur un smartphone. Je vois mal Apple ou Samsung fournir un filtre à pince avec leur tel ^^ Bien sûr ce n'est pas non plus exploitable en l'état vu la puissance requise!

Si un AlienWare peut être intéressant pour les jeux, ce n'est clairement pas le genre de machine utile ici. La carte graphique ne sert à rien pour cet algorithme ;-) Sinon, il y a eu quelques projets sur Kickstarter et autres avec des filtres pour smartphones, fixés avec des pinces. Ça coûte trois fois rien (encore moins cher qu'un filtre pour reflex, vu la surface à couvrir), et ça existe déjà. Je ne dis pas que cet algo n'a aucun intérêt, et j'admire le côté technique, mais… la solution d'Opi est moins onéreuse et tout aussi simple à mettre en place.

Je rigole ;)

Lol il faut prouver ca?

Prouve le ?

Sont des magiciens chez Google :-)

C'est bien pour un reflex mais pour une implémentation répandu un traitement logiciel est quand même bien plus exploitable, surtout pour les smartphones (tant est que le traitement ne prenne pas 20min sur un Alienware ^^)

Un génie vraiment ... Applaudissements !!

Souvent ça s'ouvre mais pas complètement. C'est comme ça dans plein de tours. Enfin bon il chipote alors je chipote aussi.

La définition d'une fenêtre est justement une ouverture. À ne pas confondre avec vitre.

Tu seras étonné de découvrir que plein de gens dans le monde vivent et travaillent dans des bâtiments avec des fenêtres qui ne s'ouvrent pas complètement. Incroyable je sais.

Mais c'est moins fun sinon !

Ok merci pour les informations supplémentaires. Donc, en effet je pencherais plus de ton côté, ça risque d'être difficile à optimiser :p

Exact. Pas besoin d'un pc surpuissant en plus.

Dans l'article original (http://people.csail.mit.edu/mrub/papers/ObstructionFreePhotograpy_SIGGRAPH2015.pdf), ils indiquent avoir déjà fait une optimisation de manière mathématique. Je pense que ce qu'ils entendent par non optimisé, c'est l'implémentation. Par contre, ils indiquent également que sur les 64 Go de la machine, seuls 3 ont été utilisés, donc mon commentaire précédent est à nuancer…

Je ne le congratule pas, je le remercie pour avoir mis en lumière une erreur de ma part. En revanche, son comportement laisse en effet à désirer.

Sinon il existe déjà des filtres polarisants à placer devant l'objectif qui peuvent servir à ça, et pour beaucoup moins cher...

Oui ça ne sera peut être pas facile à optimiser, mais je ne pense pas que la puissance de la machine soit un facteur si important que ça. Dans l'article on peut lire " À leur décharge, les chercheurs utilisaient un code source non optimisé." Quand on optimise mathématiquement un problème, le temps de calcul peut être considérablement réduit (ce n'est qu'un euphémisme vu qu'on peut passer d'un temps d'une heure / jour / mois, à une seconde). Tout dépend de la nature du problème (sa complexité est - elle polynomiale, exponentielle, s'agit - il d'un problème NP-Hard...). Dans ce cas il est possible de l'aborder différemment. Donc je pense que oui, le temps de calcul pourra être largement amélioré.

En tout cas, si le nombre de pixels est le facteur le plus important, il y aurait peut-être une piste à explorer : réduire la taille de l'image, effectuer une première passe dessus, l'upscaler, et utiliser les données de l'image originale pour récupérer les détails…

Certes il n'y a pas mis les formes (ou plutôt, pas forcément dans le bons sens), mais il a tout de même soulevé une réelle faute.

Le mec se moque de toi et tu le congratules quand il s'en prend à un autre. T'es pas un peu maso (et irrespectueux de la communauté) ?

Tu veux dire qu'il existe encore des gens aujourd'hui qui font attention au sens des mots ? Wow… on en apprend tous les jours !

Pas aussi certain que toi que ça s'optimise si facilement que ça. On n'a pas les infos dans l'article, mais le PC utilisé a quand même l'air de ne pas être ridicule niveau performances, et malgré ça, passe 20 minutes à traiter une photo qui ne fait pas la moitié des résolutions communément utilisées par les appareils photos aujourd'hui. Entre le téléphone qui met deux minutes et l'ordinateur qui en met vingt, on a un facteur dix en temps, alors qu'on n'a qu'un facteur 5 en nombre de pixels. Ça a l'air assez exponentiel… Et il y a 64 Go de RAM. Quelque chose me dit qu'ils ne sont pas là pour faire joli. À titre de comparaison, une photo en 1080p (deux mégapixels donc, à la louche) comporte ~2,5 fois plus de pixels à traiter…

Nan mais laisse tomber, les ingénieurs adorent se compliquer la vie avec des algorithmes.

Pareil pour les sous-marins. C'est quand même enfantin...

En effet, merci :)

Pourtant avec une petite vinaigrette...

Excuse moi de ne pas mélanger les choux avec les choux-fleurs.

Lol, là c'est de la mauvaise foi :p

Oui mais ouvrir la fenêtre c'est pas drôle

Dans ce cas ce ne sont pas des fenêtres, mais des vitres ou hublot. Dans l'article c'est mentionné fenêtre ( une vitre ou hublot qui s'ouvre), donc apprends la signification des mots avant de la ramener.

Vraiment intéressant cet algorithme ! Je pense que le temps de calcul pourra facilement s'optimiser (un peu de recherche opérationnel et le tour est joué, enfin faut espérer). Et un mode "anti-reflet" sur smartphone ou APN numérique ça serait vraiment utile!

Ah mais oui bien sûr ! Comment n'y avais-je pas pensé !

Bah depuis l'avion du ouvre le hublot, tout simplement

Et tu l'ouvres comment la fenêtre lorsque tu prends une photo depuis un avion / hélicoptère / immeuble... ?

"Il vous arrive souvent de prendre des photos par la fenêtre et d’être fortement déçu par le rendu final à cause des reflets dans la vitre ?" Mon équipe d'ingénieurs et moi même travaillons depuis des années sur ce problème. Après le débauchage de plusieurs ingénieurs reconnus mondialement, nous avons enfin trouvé le procédé révolutionnaire qui solutionnerait ce problème: Ouvrir la fenêtre!

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et .

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.