On savait que Raspberry Pi s’intéressait à l’IA, mais là, ils passent clairement à la vitesse supérieure. Après une première tentative timide orientée vision par ordinateur, la fondation revient avec le AI HAT+ 2. Cet accessoire permet l’exécution de modèles de langage (LLM) directement sur la carte, en local, sans envoyer vos données chez OpenAI ou Google.

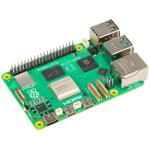

Concrètement, c’est un module qui vient se visser sur votre Raspberry Pi 5 via l’interface PCIe. Et ce n’est pas un simple gadget. Avec un prix avoisinant les 145 euros (soit plus cher que le Pi lui-même dans certaines configurations), c’est un investissement sérieux. Mais qu’est-ce qu’on a vraiment pour ce prix-là ? C’est ce qu’on va voir.

Pourquoi louer votre stockage quand vous pouvez l’acheter ? L’offre Lifetime 2 To de pCloud est à seulement 279 € (au lieu de 599 €) pour 99 ans d’utilisation.

Une fiche technique très correcte

Sur cette mini carte, on retrouve une puce Hailo-10H. Si ce nom ne vous dit rien, sachez que c’est un accélérateur neuronal capable de délivrer 40 TOPS (Trillions d’Opérations Par Seconde) en précision INT4. Pour vous donner un ordre d’idée, c’est le niveau de performance des NPU (Neural Processing Unit) que l’on trouve dans les derniers processeurs Intel Core Ultra ou AMD Ryzen AI 300. Avoir ça sur un Raspberry Pi, c’est assez fort.

Mais la vraie « killer feature », ce n’est pas tant la puissance de calcul brute. C’est la mémoire. L’AI HAT+ 2 embarque 8 Go de RAM LPDDR4X dédiée. Pourquoi c’est important ? Parce que d’habitude, quand vous lancez un modèle d’IA sur un Raspberry Pi, il cannibalise la RAM du système, rendant tout le reste lent ou instable. Ici, le NPU a son propre terrain de jeu. Le processeur principal et la RAM de votre Pi 5 restent libres pour gérer l’OS et vos autres applications.

Raspberry Pi promet ainsi que vous pourrez faire tourner des modèles comme DeepSeek-R1-Distill, Llama 3.2, Mistral ou Qwen. On parle de modèles entre 1 et 1,5 milliard de paramètres au lancement, avec la possibilité d’aller plus haut par la suite. C’est une architecture technique très maligne qui déleste complètement le CPU.

Le diable se cache dans les détails

Si les chiffres font rêver, la réalité physique impose ses limites. La puce Hailo-10H intégrée ici est bridée à une consommation de 3 Watts. C’est excellent pour l’efficacité énergétique, mais ça limite les performances brutes.

C’est là que le positionnement devient délicat. Si vous avez déjà un Raspberry Pi 5 avec 16 Go de RAM, vous avez déjà une machine capable de charger de gros modèles en mémoire. Certes, c’est le CPU qui travaille (et il va souffrir), mais vous n’avez pas la limitation des 8 Go de la carte d’extension. Pour les très gros modèles quantifiés qui demandent 10 ou 12 Go de RAM, cet accessoire sera paradoxalement moins capable qu’un Pi 5 « nu » bien doté en RAM.

De plus, l’installation physique condamne l’accès facile aux GPIO si vous n’utilisez pas le réhausseur fourni, et le refroidissement peut devenir un sujet si vous empilez les HATs. C’est une solution pensée pour l’efficacité et l’inférence dédiée, pas forcément pour la force brute absolue.

Utilisez-vous Google News (Actualités en France) ? Vous pouvez suivre vos médias favoris. Suivez Frandroid sur Google News (et Numerama).

Ce contenu est bloqué car vous n'avez pas accepté les cookies et autres traceurs. Ce contenu est fourni par Disqus.

Pour pouvoir le visualiser, vous devez accepter l'usage étant opéré par Disqus avec vos données qui pourront être utilisées pour les finalités suivantes : vous permettre de visualiser et de partager des contenus avec des médias sociaux, favoriser le développement et l'amélioration des produits d'Humanoid et de ses partenaires, vous afficher des publicités personnalisées par rapport à votre profil et activité, vous définir un profil publicitaire personnalisé, mesurer la performance des publicités et du contenu de ce site et mesurer l'audience de ce site (en savoir plus)

En cliquant sur « J’accepte tout », vous consentez aux finalités susmentionnées pour l’ensemble des cookies et autres traceurs déposés par Humanoid et .

Vous gardez la possibilité de retirer votre consentement à tout moment. Pour plus d’informations, nous vous invitons à prendre connaissance de notre Politique cookies.